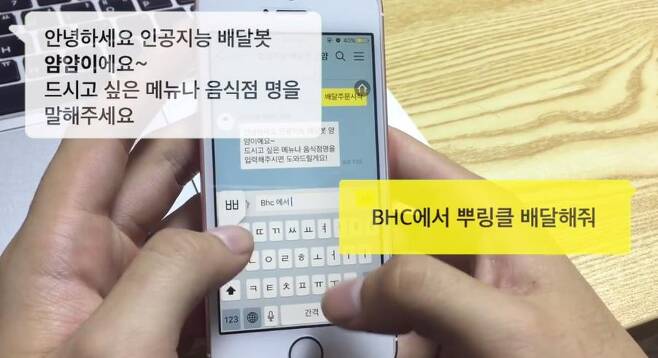

방금 당신과 대화했던 챗봇은 정말 로봇이었을까요?

인공지능 서비스를 만드는 것은 어렵습니다. 실제로 너무 어려워서 일부 스타트업에서는 기계가 인간처럼 행동하게 만들기보다 사람이 로봇처럼 행동하게 하는 것이 더 저렴하고 쉬운 방법임을 알아냈습니다(!!!).

'가짜 인공지능'을 많이 만났다는 리드미(ReadMe)의 최고경영자 그레고리 코버거는 말합니다.

“사람이 작업을 하면, 여러 가지 기술적 문제와 사업 개발 문제들을 건너 뛸 수 있습니다. 확장은 무리지만 초기에 어려운 부분을 건너뛰고 필요한 것들을 만들게 해줍니다. 본질적으로 사람으로 인공지능 제품 원형을 만드는 거죠.”

이런 관행은 이번 주 월스트리트 저널 기사에서 밝혀졌습니다. 기사는 구글이 수백 명의 외부 애플리케이션 개발자들에게 유저들의 받은편지함에 대한 액세스를 허용했다는 내용을 다루고 있었죠. 즉, 인공지능이 아닌 인간이 우리의 메일들을 확인하고 있었다는 뜻입니다.

캘리포니아주 새너제이(San Jose)에 본사가 있는 에디슨 소프트웨어의 인공지능 개발자들은 “스마트 답변” 기능을 개선하기 위해 사용자 수백 명의 개인 메일을 자신들의 신분을 숨기고 살펴보았습니다. 이 회사는 사용자의 이메일을 인간이 본다는 사실을 개인정보 보호 정책에 명시하지 않았습니다.

이번 월스트리트 저널에 실린 외부 애플리케이션 회사들이 결코 처음은 아닙니다. 2008년 음성 메일을 문자 메세지로 전환하는 회사인 스핀복스(Spinvox)는 전환작업에 기계가 아닌 해외에 있는 고객 센터의 사람을 이용했다는 혐의를 받았습니다

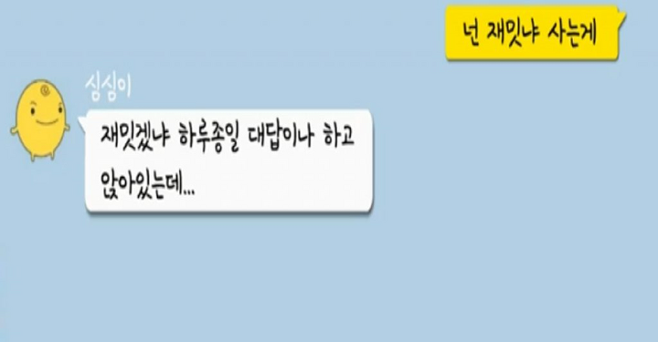

2016년 블룸버그지는 엑스에이아이(X.ai)와 클라라(Clara) 같은 스케줄링 서비스에 챗봇을 가장한 인간이 하루 12시간씩 일하는 비참한 상황을 소개한 바 있습니다. 그 일이 너무나 단순한 일이어서 인간 노동자들은 곧 기계 봇이 자신들의 일을 대체하기를 고대한다고 말했습니다.

2017년 업무 비용 관리앱 익스펜시파이(Expensify)는 '스마트스캔 기술'을 사용하여 처리한다고 주장한 영수증 일부를 인간이 기록했음을 인정했습니다. 아마존의 메케니컬 터크(Mechanical Turk, MTurk)라는 크라우드 소싱 툴에 스캔된 영수증을 올려서 저임금 노동자가 영수증을 읽고 이를 기록처리하게 했다는 것입니다.

“Expensify 스마트스캔 사용자들은 자기 영수증을 MTurk 노동자들이 직접 입력한다는 사실을 알까요?”라고 메케니컬 터크 노동자이자 트위터에서 긱 이코노미(Gig economy) 노동자를 옹호하는 로첼 라플란테는 말했습니다.

심지어 인공지능에 상당히 많이 투자한 페이스북도 메신저 가상 도우미 서비스 ‘M’에 인간의 도움을 받았습니다.

어떤 경우는 사람이 인공지능 시스템을 훈련시켜서 정확도를 높입니다. 스케일(Scale)사는 자율 주행 및 기타 인공지능으로 만든 시스템에 훈련 데이터를 제공하는 인력 은행을 운영합니다.

“스케일러”라고 불리는 인간 노동자들은 카메라나 센서 피드를 보고 프레임에 있는 자동차, 보행자, 자전거를 탄 사람에게 라벨을 붙입니다. 충분한 인간의 미세 조정을 통해 인공지능은 이런 사물들을 스스로 알아보는 방법을 배웁니다.

또 다른 경우에는 회사들이 비밀리에 인간의 지능에 의존하면서 투자자와 사용자에게는 확장 가능한 인공지능 기술을 만들었다고 말합니다.

정신 건강 챗봇 우봇(Woebot)의 창립자인 심리학자 앨리슨 달시는 이런 방식을 '오즈의 마법사 디자인 기술'이라고 부릅니다. 앨리슨은 이렇게 말했습니다.

“앞으로 일어날 궁극적인 경험을 시뮬레이션 하는겁니다. 인공지능 분야에 있어서 많은 경우 실제 알고리즘보다는 커튼 뒤에 사람이 숨어서 인공지능인 척을 하는 거죠.”

연구에 의하면 사람들은 인간보다 기계에게 말한다고 생각할 때 더 많은 부분을 솔직하게 말하는 경향이 있습니다. USC 대학의 연구팀은 엘리(Ellie)라고 불리는 가상 심리치료사를 통해 실험했습니다.

연구팀은 외상 후 스트레스 장애를 앓고 있는 퇴역 군인들이 엘리가 사람이 통제하는 기계라는 말을 들었을 때 보다 인공지능 시스템이라고 알고 있을 때 자신들의 증상을 좀 더 솔직하게 털어놓는다는 사실을 발견하였습니다.

사람들은 회사가 자신들의 서비스 운영 방식에 대해 솔직히 털어놓아야 한다고 생각합니다. 라플란티는 인공지능 서비스를 제공하는 것처럼 가장하면서 실제로 사람을 사용하는 회사들을 “좋아하지 않는다”고 표현하면서 이렇게 말했습니다.

“정직하지 않고 속이는 것 같아요. 내가 사용하는 비즈니스는 그러지 않기를 바라죠. 그리고 노동자 입장에서는, 커튼 뒤에 숨어서 거짓말을 강요받는 느낌이잖아요. 저라면 회사가 직원을 이용하고 고객들에게 실제로 무슨 일이 일어나는지 거짓말하는걸 보고 싶지 않을 것 같아요.”

그런데 이런 윤리적 딜레마는 인간인 척하는 인공지능 시스템에서도 나타납니다. 최근의 예로는 로봇 도우미 구글 듀플렉스가 사람 목소리로 전화를 하면서 “음” 같은 어구를 사용해서 예약을 하는 시범이 있습니다. 발표 이후 사람들의 반발이 일자, 구글은 듀플렉스가 인간에게 이야기를 할 때 자신이 인공지능임을 밝히게 하겠다고 했습니다.

"시범 버전에서는 영향이 적은 대화라서 속이는 느낌이 미미하게 있습니다"라고 달시는 말했습니다. 레스토랑 예약하기는 아주 큰 위험이 없는 대화같이 보이지만, 같은 기술이 나쁜 사람의 손에 들어가면 훨씬 더 교묘한 속임수로 사용될 수도 있습니다.

예를 들어 여러분이 연예인이나 정치인의 목소리를 똑같이 흉내 내는 인공지능과 전화를 한다면 어떤 일이 일어날까요? 달시는 다음과 같이 말합니다. “인공지능에 대해 이미 큰 두려움을 갖고 있는데, 투명하지 않은 대화는 전혀 도움이 되지 않을 것입니다.” 가디언

번역: 뉴스페퍼민트