친구 얼굴을 '고릴라'로 인식한 구글, 문제 개선했을까?

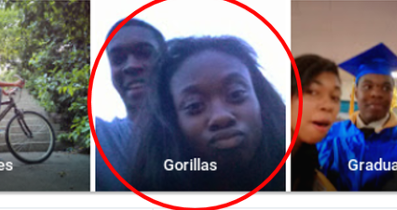

2015년 6월, 미국에 사는 흑인 남성 재키 앨신(Jacky Alcine)은 자신의 트위터에 구글에 대해 분노하는 글을 올렸다. 정확히 말하면 '구글 포토'의 잘못된 알고리즘 결과를 비판한 것이었다. 구글 포토는 앨신과 그의 흑인 친구가 함께 찍은 사진에 'gorillas'라고 태그를 달았다. 단지 피부색이 까맣다는 이유로 잘못된 알고리즘 결과가 나온 것이다.

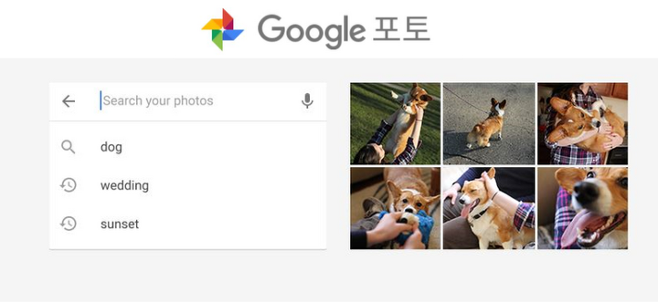

구글 포토는 사진과 동영상을 무제한 저장공간에 백업해서 안전하게 관리해주는 서비스다. 구글 포토를 이용하면 사진이 카테고리별로 정리되고 검색이 가능하다. 예를 들어 '강아지'를 검색하면 모든 강아지 사진이 검색 결과로 나타나는 방식이다.

구글은 이 불미스러운 사건에 대해서 재빨리 사과했다. 구글 플러스 수석 엔지니어인 요나탄 정거(Yonatan Zunger)는 "더 이상 잘못된 태그가 붙지 않도록 알고리즘 기술을 대대적으로 수정하겠다"라고 밝혔다.

약 3년이 지난 현재, 구글 포토의 알고리즘 기술은 어디쯤 와있을까? 2018년 1월, 미국의 월간 잡지 <와이어드wired>가 실험해 본 결과 불행히도 아직 갈 길이 멀었다.

개코원숭이는 되고 고릴라는 안된다?

와이어드는 구글 포토에 4만 장의 동물 사진을 저장한 뒤 그들이 어떤 식으로 분류되는지 알아보기로 했다. 검색창에 판다, 푸들 등 여러 동물의 이름을 입력하자 관련된 사진이 제대로 분류되어 나타났다. 마찬가지로 개코원숭이, 긴팔원숭이, 오랑우탄을 검색했을 때도 알고리즘이 제대로 작동했다.

그러나 '고릴라'를 검색한 경우에는 달랐다. 실제로 구글 포토에 고릴라 사진이 있더라도 '고릴라', '침팬지', '원숭이' 단어를 입력하면 관련된 사진은 아무것도 나오지 않았다. 알고 보니 구글은 단지 알고리즘에서 '고릴라' 단어를 삭제함으로써 일시적으로 알고리즘의 인종 차별 문제를 수정했던 것이었다. (관련된 말인 침팬지와 원숭이도 검색을 금지시켰다.) 사람들은 대대적으로 알고리즘을 수정하지 않고 단지 단어를 제외한 것에 그친 구글의 대처방안에 대해 비난했다.

와이어드는 알고리즘이 인종을 제대로 구분할 수 있는지도 추가로 시험해보기 위해 1만 장 이상의 다양한 인종의 얼굴 사진을 구글 포토에 업로드했다. 그리고는 흑인을 의미하는 단어 'black man', 'black woman', 'black person'을 차례로 입력했다. 하지만 구글 포토는 제대로 된 흑인 사진이 아니라 단지 흑백사진만을 결과로 보여줄 뿐이었다. 성별은 제대로 분류했을지 몰라도 역시 인종은 필터링하지 못한 것이다.

구글 관계자는 "사진 인식 머신 러닝 기법은 여전히 초기 단계에 머물고 있지만 사용자로 하여금 적극적으로 구글의 실수를 보고하도록 장려하고 있다"라는 점만 강조할 뿐이었다. 또한 "재키 앨신 때의 일이 반복되지 않도록 알고리즘을 전반적으로 수정하는 장기적인 작업을 하고 있다"라고 밝혔다.

잘못된 사회적인 편견이 반영된 알고리즘 사례도 있다. 2016년에 구글은 인종 차별적인 검색 결과로 빈축을 산 적이 있다. 당시 구글 이미지 검색창에 'three white teenagers(세 명의 백인 청소년)'라고 검색하면 화목해 보이는 백인 사진들이 나왔다. 그러나 'three black teenagers(세 명의 흑인 청소년)'라고 검색했을 때는 범죄자의 사진으로 가득 차 있는 영상이 나왔다.

안타깝게도 알고리즘은 절대 객관적이지 않다. 오히려 인간보다 더 차별적일 수 있다. 인간이 만들어내는 검색 데이터가 축적됨에 따라 알고리즘도 사용자들이 갖고 있는 잘못된 생각을 그대로 학습하기 때문이다. 그리고 이 알고리즘은 다시 사람들의 편견을 강화할 수밖에 없다. 알고리즘이 차별적 논란에서 자유로운 검색 결과를 스스로 내놓을 확률은 제로다. 머신 러닝 기법을 개발하는 관리자들은 차별을 일으킬 수 있는 잠재적 요인들을 무시하지 말고 적극적으로 문제를 모니터링하고 대처해야 할 것이다.

inter-biz@naver.com